「ChatGPT等AIの急速な発展の理解とこれからの社会経済」

中央学院大学 小林 和馬 准教授

近年、AI(人工知能)や「ChatGPT」が急速に発達しています。これらの最新技術は私達の雇用や生活をどのように変化させるのでしょうか。新年号に当たり、中央学院大学商学部の小林和馬准教授(専門はICT政策の経済分析や「AIと雇用」)に、最新技術の動向と私達への影響に関して寄稿いただきました。

生成AIが急速に発達 偽情報の氾濫に注意が必要

文字情報を元に画像や音声を生成

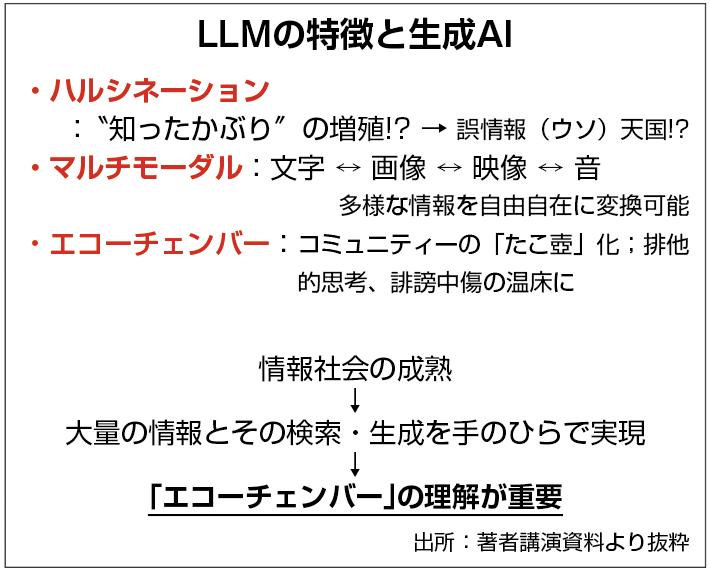

2023年はChatGPTを中心とした大規模言語モデル(LLM)が広く利用されるようになった年でした。同時に、生成AIと呼ばれる画像、映像、さらには音声といった多様な情報を、文字(テキスト)情報から生成可能になりました。これは「マルチモーダル」(下図)と呼ばれ、多様な情報について、自由かつ相互に変換できるようになりました。

これらのことから、2023年はAI(人工知能)にとって急速な変化を迎えた濃密な一年と言えます。

便利な機能の影で偽情報氾濫に注意

そもそも「LLM」とは、次にくる言葉を確率論的に選び出すものに過ぎません。例えば「日本の首都は」と聞かれたら、「東京」を選ぶようなものです。しかし、日本の歴史を知っていれば、首都は奈良や京都だったこともあります。それを大量の文字情報から、確率論的に「東京」と判断しているに過ぎないのです。

そのため、LLMは本質的に「偽情報」として誤った情報が大量に存在すると、それを「正しい」と判断し、「知ったかぶり」をしてしまいます。これを「ハルシネーション」と呼びます(上図)。

したがって、インターネット時代からSNS時代に移り、フェイクニュースやヘイトのように誤っていたり偏っていたりする情報が大量に流布されている現状では、LLMはこの状況を大きく助長する「エコーチェンバー」を生む可能性さえあります(上図)。

実際、すでに生成AIを用いた偽情報が氾濫を始めています。2024年以降はしばらくの間、偽情報と世界の政治情勢の相乗作用によって、時に世間が混乱する危険性があります。さらに、情報が無料で大量に得られる現状をふまえると、事実やその背後にある価値観を精査することが困難な時代が到来する可能性もあります。

今後、正確な情報や信頼できる情報を探し求め、選び出す必要がある時代が来るかもしれません。

人間と機械の関係が変化 AIに仕事を奪われる?

AIの発達によってパラダイムシフトへ

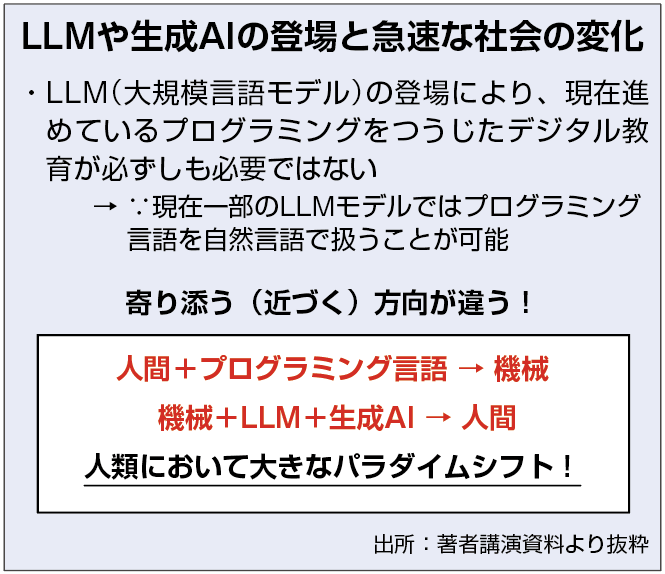

一方で、このLLMの登場で、一つの大きなパラダイムシフトが起こりました。

これまで、有史以来、人間と機械の関係は、人間が使い方を工夫し、機械の調子を見ながら、時に機械の言葉(プログラム言語)を覚え、機械に動いてもらい、求める結果(出力)を得るという「人間が機械に近づき、寄り添う」というものでした。

LLMの登場はその関係性を真逆にしました。つまり、「機械が人間に近づき、寄り添う」という関係です。「なにをどうしたいのか」について、人間は求めるものを「言葉(自然言語)」で伝え、すべて機械が言葉を理解し工夫します。「もっとこうして」と要求することも可能です。

この関係性の変化は、それまでとは全く異なる世界観であり、これは革命的変化と言えます。

人間に近づくAI 雇用への影響は

専門的なAIの議論に目を向けると、2023年には、いくつかの重要な知見が得られました。

現在、とくに懸念されているのはカーツワイル(2007年)の提唱した「シンギュラリティ」です。これは、AIが人類の知能を超える可能性を指摘するものです。

この懸念を助長する契機となったのがフレイとオズボーンの論文(2013年)です。このなかでは、AIによって「労働人口の47%の職を機械が奪う」とされました。また、オズボーンと野村総研(2015年)では、「日本の労働人口の49%が人工知能やロボット等で代替可能に」とされ、懸念に拍車がかかりました。しかし、これらの主な議論は米国の雇用分類にもとづいた米国雇用への影響の分析であり、世界的な議論とするには不十分でした。

2023年、ILO(国際労働機関)はAIによる雇用の影響を国際的な統計データで分析しました。この分析は、先行研究とほぼ同じ方向性で「多くの職が中程度の影響を受ける」「4分の1の職で高いレベルの自動化の危機」といった結論を示しました。また、この分析は、世界中でAIによる雇用への影響があることも示しました。

一方で、多くの職業でAIが職を「奪う」ものではないことが明らかになりました。

さらに、2023年はChatGPTの議論から重要な論文が公開されました。2023年4月6日、ネイチャー誌で発表された論文は、「ChatGPTの生成した回答が人間の選択に影響を与えるかもしれない」という結果を示しました。

この結論の含意は重大です。つまり、LLMによって生じた偽情報やハルシネーションの出力結果を人間が「鵜呑み」にしてしまうリスクです。これは偽情報にもとづいた価値観や社会を真実であるかのように、具現化・実現してしまう危険性を示唆しています。

同誌は同年10月25日の紹介記事で「AIのブレークスルーだ」という見出しを付けた重要な知見を含む論文を公開しました。

これまでAIは「ニューラルネットワーク」と呼ばれ、人間の脳の神経細胞を模しているが、人間の知能とは原理的に異なるものとされていました。しかし、ここで紹介された論文では認知科学を利用し、学習方法の異なるLLMを組み合わせて出力すれば、AIの回答が人間の答えに近づくかもしれないと分析しました。この論文は異なる種類の学習を行うLLMを組み合わせると、AIが人間の知能に近づく可能性を初めて証明しました。

このように現在の分析は、学問の分野を越えて多分野にわたる研究を総合して行われます。この点は、これからの日本の教育のあり方にも示唆を与えるものです。いずれにしても、この研究も、ようやくLLMをつうじ、AIが人間の知能に近づく可能性を示したものに過ぎず、シンギュラリティがすぐに訪れ多くの職が奪われることはありません。偽情報に踊らされないようにしましょう。

AIを日常生活で活用しさまざまな課題解決を

各国で規制が進展今後さらに加速へ

近年、ChatGPTを含むLLMに対する規制や政策が急速に議論され、矢継ぎ早に公表されています。これは現時点ですでに偽情報が氾濫し始めていることから、各国としても「走りながら考える」状況にあるためです。

2023年5月に日本(広島県)で開催されたG7サミットにおいてAIに関する問題性が指摘され、国際的な枠組みで対策や政策を検討することが決定されました。その後、同年10月には、「広島AIプロセスに関するG7首脳声明」が公表されました。

こうした国際的な議論をふまえ、米国は昨年10月23日に大きく7項目の対策を含んだ政策を発表しました。これは、方針の表明に近い内容でしたが、このスケジュール感とスピード感で規制や政策が立案・施行されていく姿から、いかにAIの利用が急速に広がっていて影響が広大になっているかが分かります。

実際に、その後、英国において、総勢28カ国とEUが米国とほぼ同様の方針を示した「ブレッチリー宣言」の合意を発表しています。このように、ChatGPTに代表されるLLMや生成AIへの対応はまだ始まったばかりです。

AIを「道具」に積極的に活用する

一方で、現時点では大規模言語モデル(LLM)は、あくまでも「道具」のレベルと言えます。つまり、人類の進化・発展のなかで登場した道具、例えば刃物や自動車、インターネット、SNSなどと同様です。「正しく使えば」なんの問題もありません。人類の歴史が示すように、われわれは道具によって、さまざまな問題を解決し、豊かな生活を手にしてきました。

超少子・高齢化社会や人手不足といった日本に横たわる問題も同様です。雇用については米国のように労使の混乱があったとしても、「奪われる」ものではなく、AIによる自動化で不足する人材を静かに「埋め合わせる」ものになるはずです。むしろ、見方を変えれば、日本は世界と比較してもスムーズにAIを導入できる環境にあると言えます。

いま日本では、すでに問題が顕在化している一方、解決策が見出せておらず、いますぐ対処する必要があります。しかも、経済的・財政的な余裕はありません。

これからの日本では、AIを恐れるのではなく、日常生活に積極的に取り入れていく心構えを持つことがより良い社会や生活をつくる第一歩となるでしょう。

小林 和馬 准教授